Geometric Enclosing Networks

Geometric Enclosing Networks

问题: GEN是什么,有什么有价值的东西?

回答: GEN是一种生成网络,与VAE,GAN相比,它没有直接估计分布密度,没有直接度量$P_{data},P_{model}$。引入几何解释与核方法。

Model

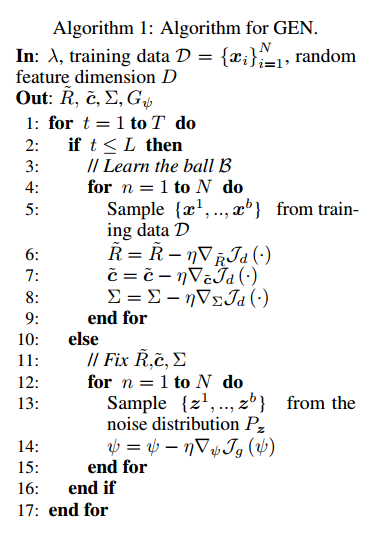

模型分为两大步骤,首先把实际数据核嵌入到encloing ball $\mathcal B$上,参数包括核参数$\Sigma$,球心$c$,球半径$R$。然后,保持第一步训练得到的参数不变,在随机噪声$z$的基础上通过生成神经网络$G(z)$,再通过特征映射$\Phi$到球上,通过调整神经网络参数来实现。

Fourier Random Featrue Representation

目的:傅里叶变换便于计算特征映射。

Bochner定理指出位移不变的半正定核可以表示为:

$$

K(x,x’)=K(x-x’)=\int p(w)\exp(iw^T(x-x’))dw

$$

当为高斯核$K(x,x’)=\exp((x-x’)^T\Sigma(x-x’)$的情况下:

$$

p(w)=\mathcal N(0,\Sigma)

$$

进一步计算可以求出近似的特征映射:

$$

K(x,x’)=\mathbb E_{w \sim p(w)}[\cos(w^T(x-x’))] \approx \frac{1}{D}\sum_{i=1}^D[\cos(w_i^T(x-x’))]

$$

$$

\Phi(x)=[\frac{1}{\sqrt{D}}\cos(w_i^Tx),\frac{1}{\sqrt{D}}\sin(w_i^Tx)]_{i=1}^D

$$

Loss Function

$\min J_d$尽可能使数据映射到一个球上,半径尽可能小。

$$

J_d(R, c, \Sigma)=\lambda R^2+\frac{1}{N} \sum_{i=1}^N \max(0, \parallel \Phi(x_i)-c \parallel-R^2)

$$固定第一步的参数,尽可能使生成网络产生的数据也同样映射到球内,$\min J_g$

$$

J_g(\psi)=\mathbb E_{z \sim p(z)}[\max(0, \parallel \Phi(G_{\psi}(z))-c \parallel^2-R^2)]

$$

Procedure

Some Thought

Q:为什么要映射到球上?

A:我不知道。但我想起了黎曼映射。

黎曼映射定理, Riemann mapping theorem

存在一个映射$f:\Omega \to D$,$\Omega \notin \mathbb C$是单连通的开集,$D={z\in \mathbb C:|z|<1}$是开单位圆盘,而且这个映射是双全纯的。

在复分析里,共形映射是全纯函数。